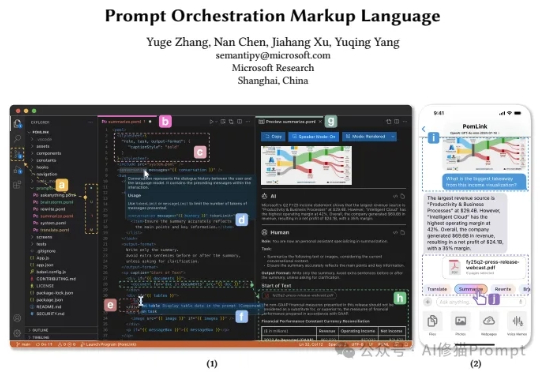

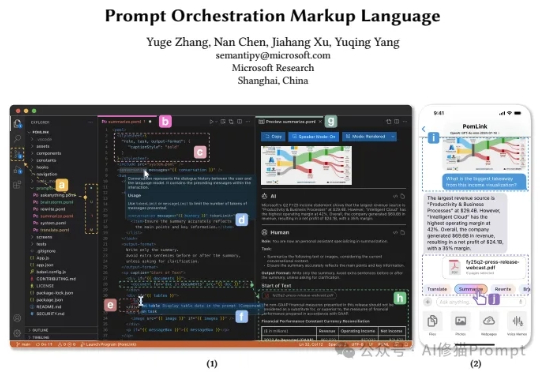

搞不定有表格数据和多模态的Prompt?试下微软最新的提示词编排标记语言POML

搞不定有表格数据和多模态的Prompt?试下微软最新的提示词编排标记语言POML最近来自微软的研究者们带来了一个全新的思路,他们开源发布了POML(Prompt Orchestration Markup Language),它的的解决方案它的核心思想非常直接:为什么我们不能像开发网页一样,用工程化的思维来构建和管理我们的Prompt呢?这个编排语言很类似IBM的PDL

最近来自微软的研究者们带来了一个全新的思路,他们开源发布了POML(Prompt Orchestration Markup Language),它的的解决方案它的核心思想非常直接:为什么我们不能像开发网页一样,用工程化的思维来构建和管理我们的Prompt呢?这个编排语言很类似IBM的PDL

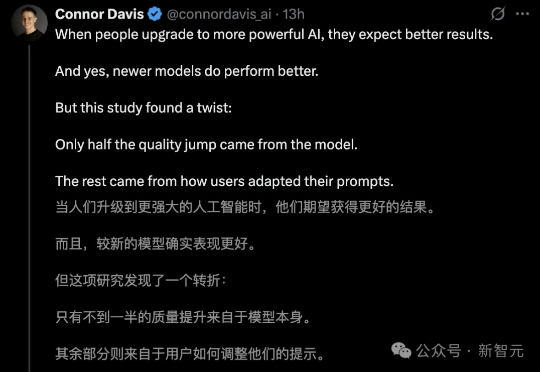

提示词才是AI隐藏的王牌!马里兰MIT等顶尖机构研究证明,一半提示词,是让AI性能飙升49%的关键。

除了是知名 AI 播客「No Priors」的主理人之外,Sarah Guo 更知名的身份,是风险投资 Conviction 的创始人。

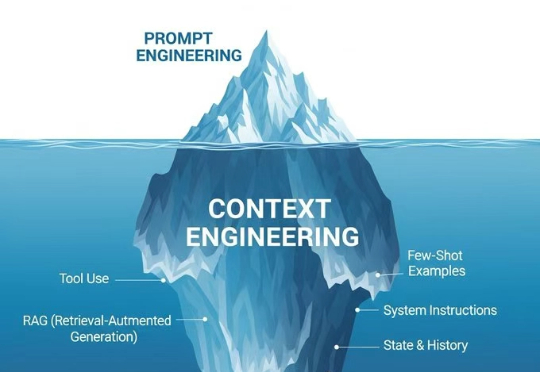

就像是播放音乐,Prompt Engineering是在调音响的音量,那Context Engineering就是在设计整个音响系统,从音源、功放、音箱到房间声学,每个环节都要精心设计。Context Engineering本质上是设计和优化AI模型整个上下文窗口的工程学科。这不只是一个技术升级,更像是思维模式的根本转变。

现在再讨论 AI 写作,多少有点没劲:prompt 真的越来越像咒语了,越来越像一些神秘不可洞察的玄学技巧。这导致使用 AI 写东西的过程,不管是写什么类型的文字,过程都跟做法似的:赌指令能不能触发出一些好的生成。同时还得用大量的指令,去掉「AI味」。

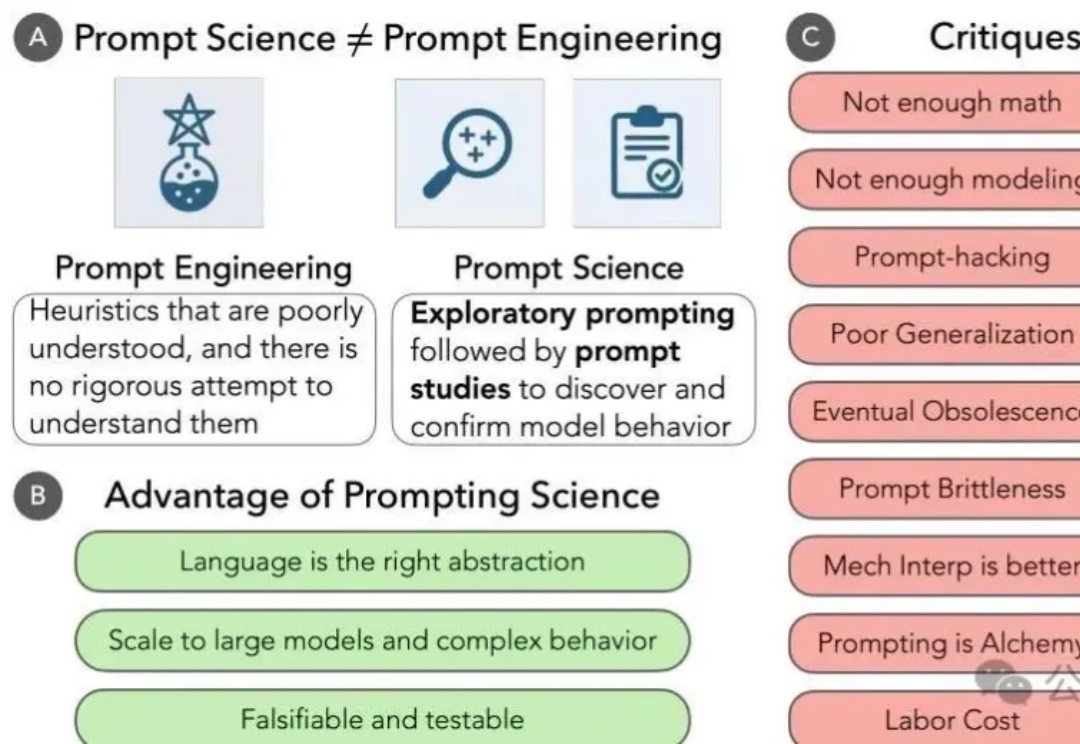

最近网上出现了一些很有趣的声音——"提示词已死"、"写提示词把自己写死了",这些文章认为随着模型变得越来越智能,精心设计提示词的时代已经过去了。但芝加哥大学的最新研究却给出了完全相反的结论:prompt不仅没有死,反而是理解大模型最重要的科学工具。

MT Park 的第12场AI分享会顺利进行!~🎉 感谢向阳乔木老师非常细致地分享了: 他探索 Prompt 的多场景实践,从 Cursor、Windsurf 等 vibe 编程工具,到 Veo3 的视频生成,覆盖编程、教育、内容创作等多个方向,带你快速上手 AI 最实用的玩法。

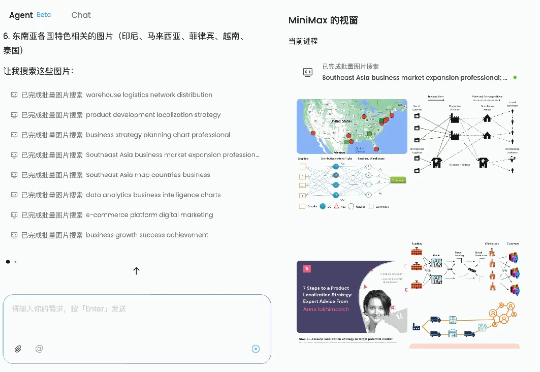

今年上半年,最吊足胃口和期待的,莫过于 Agent 工具,饼画得都很大:日常中那些烧脑、重复、耗时间的任务,现在似乎只需要动动手指、敲几行 prompt 就能搞定。

最近,Google 官方发布了一份长达 69 页的【Prompt Engineering 白皮书】,可以说是目前最系统、最权威的“AI 沟通指南”了。我们也是第一时间翻译好了这本书,准备【免费】送给大家!

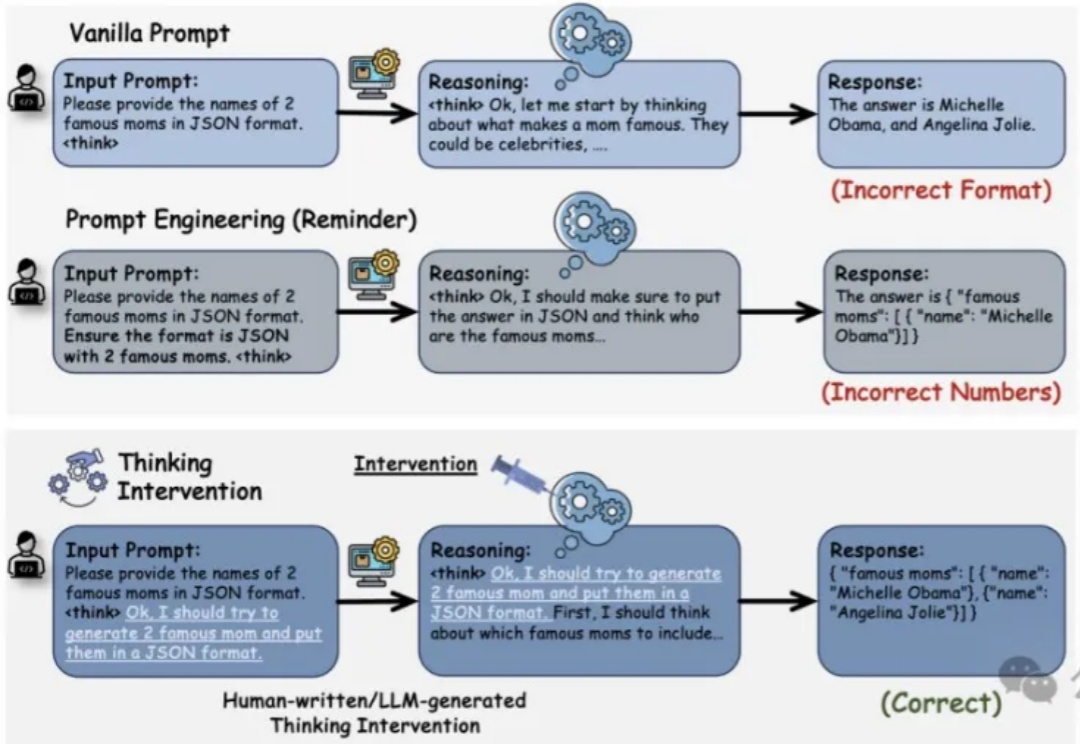

推理增强型大语言模型LRM(如OpenAI的o1、DeepSeek R1和Google的Flash Thinking)通过在生成最终答案前显式生成中间推理步骤,在复杂问题解决方面展现了卓越性能。然而,对这类模型的控制仍主要依赖于传统的输入级操作,如提示工程(Prompt Engineering)等方法,而你可能已经发现这些方法存在局限性。